10 Minutės

Įvadas ir kontekstas

Pagal Pietų Korėjos žiniasklaidos pranešimus, Samsung planuoja pristatyti 10 000 vienetų HBM3E 12 sluoksnių atminties modulių įmonės Nvidia reikmėms — tai apimtų AI serverius ir akceleratorius, skirtus dirbtinio intelekto užduotims. Jei ši informacija pasitvirtins, tai būtų reikšmingas etapas Samsung atminties padaliniui, siekiančiam stiprinti savo pozicijas aukštos pralaidumo atminties (High Bandwidth Memory, HBM) rinkoje, kuri yra esminė moderniems AI skaičiavimams.

Kas yra užsakymas ir ką tai reiškia

Pranešimo šaltiniu nurodomas korėjietiškas leidinys AlphaBiz, kuris teigia, kad sandoris apima 10 000 vienetų HBM3E 12 sluoksnių modulių. Tokio dydžio užsakymas, net jei tai būtų pradinė partija, gali reikšmingai pakeisti tiekimo grandinių dinamiką, nes HBM3E technologija yra būtina didelės spartos atminties poreikiams serveriuose, kuriuose vykdomi dideli LLM (didelės apimties kalbos modeliai) treniravimai ir realaus laiko inferencijos.

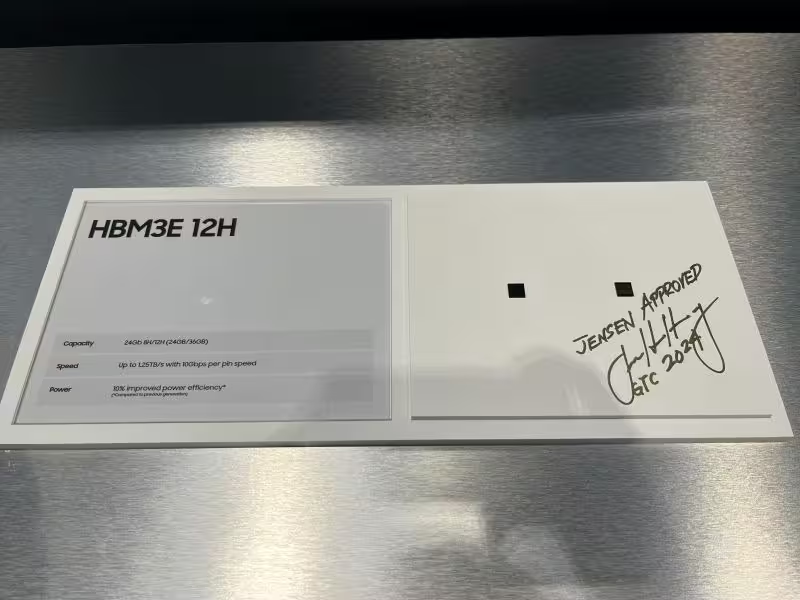

Produkto aprašymas: kas tai per moduliai

Greičiausiai tie moduliai

Analitikai ir pramonės stebėtojai mano, kad užsakymas greičiausiai apima Samsung HBM3E-12H modulius — įmonės vėliavinius 36 GB 12 sluoksnių kaupiklius, pristatytus praėjusiais metais. Šie moduliai skiriasi didele talpa ir ypač dideliu pralaidumu, siekiančiu maždaug 1 280 GB/s vienam kaupikliui, todėl jie tinka didelės apimties AI treniravimui ir inferencijoms, kur atminties pralaidumas dažnai tampa apribojimu.

Techninės savybės

HBM3E-12H moduliai, kaip ir kiti HBM3E sprendimai, pasižymi keletu pagrindinių techninių charakteristikų, svarbių AI infrastruktūrai:

- Talpa: 36 GB vienam 12 sluoksnių kaupikliui.

- Pralaidumas: iki ~1 280 GB/s per kaupiklį (maksimalios teorinės ribos priklauso nuo konfigūracijos ir integravimo į akceleratorių).

- Topologija: 12 TSV (Through Silicon Via) sluoksnių struktūra leidžia tankią atminties integraciją ir trumpus signalo takus tarp logikos bei atminties sluoksnių.

- Kompatibilumas: orientuota į aukštos spartos interfeisus, dažnai naudojama kartu su moderniais AI akceleratoriais ir GPU.

Raktažodžiai ir esminės savybės

Trumpas faktų suvestinė (pagal pranešimus):

- Šaltinis: AlphaBiz (Pietų Korėja)

- Kiekis: 10 000 HBM3E 12 sluoksnių modulių

- Greičiausiai produktas: HBM3E-12H, 36 GB vienam kaupikliui

- Pagrindinis klientas: Nvidia, skirtas AI akceleratoriams ir serveriams

Kodėl tai svarbu

Aukštos pralaidumo atmintis yra gyvybiškai svarbi šiuolaikiniams AI akceleratoriams. Dideli modeliai reikalauja greito svorių ir aktyvacijų perkėlimo tarp skaičiavimo branduolių ir atminties. HBM3E, palyginti su ankstesnėmis HBM kartomis arba tradicinėmis DDR atmintimis, suteikia išskirtinį santykį tarp talpos ir pralaidumo, todėl sumažina atminties siaurą vietą (memory bandwidth bottleneck) ir leidžia efektyviau išnaudoti akceleratoriaus skaičiavimo pajėgumus.

Tiekimo požiūriu, HBM3E gamina tik keletas gamintojų: Samsung, SK Hynix ir Micron. Tai reiškia, kad bet koks naujas tiekimo susitarimas gali pakeisti kainų, prieinamumo ir tiekimo stabilumo perspektyvas visoje vertės grandinėje. Iki šiol Nvidia dalį HBM pirkdavo iš alternatyvių tiekėjų, nes Samsung anksčiau susidūrė su kvalifikavimo ir kokybės kriterijų suderinimu; tačiau pranešimai rodo, kad Samsung galėjo išspręsti šiuos klausimus ir gauti Nvidia patvirtinimą, atverdama kelią komerciniams užsakymams.

Rinkos ir technologinis kontekstas

Augantis AI serverių poreikis

Didesnės technologijų bendrovės ir debesų paslaugų tiekėjai nuolat plėtoja AI serverių parkus ir akceleratorių diegimus — tai tiesiogiai didina HBM3E poreikį. Modelių dydis ir realaus laiko inferencijos reikalavimai skatina investicijas į atmintį, kuri gali užtikrinti tiek didelę talpą, tiek aukštą pralaidumą. AI treniravimas ir didelės apimties duomenų apdorojimas ypač vertina sprendimus kaip HBM3E dėl trumpesnių delsos laikų ir mažesnio energijos suvartojimo parduodant laukimo nuostolius.

Tiekimo grandinės įtaka

Didelis užsakymas, net jei ir pradinis, gali turėti kelias pagrindines pasekmes:

- Stiprinti Samsung pozicijas HBM rinkoje, suteikiant platesnį portfelį klientams, kurie anksčiau labiau pasikliovė kitais gamintojais.

- Suteikti Nvidia papildomą tiekėjo diversifikaciją, kas sumažina riziką dėl vieno tiekėjo sutrikimų ar kainų šuolių.

- Galimai paveikti HBM kainas ir prieinamumą visoje ekosistemoje — didesnės gamybos partijos gali slopinti kainų svyravimus, tačiau paklausos šuoliai gali sukelti trumpalaikes eilės ar kainų korekcijas.

Techninės ir kokybės prieigos

HBM3E sprendimams patekti į Nvidia gaminius reikia griežtos kvalifikacijos: patikimumas, temperatūrinis stabilumas, signalų integralumas ir galimybė veikti intensyviose darbo sąlygose. Prieš įtraukiant naują modulį į masinę gamybą, vyksta ilga testavimo fazė, apimanti gedimų analizę, ilgaamžiškumo tyrimus ir suderinamumo bandymus su pačiais akceleratoriais.

Pranešimai, kad Samsung gavo Nvidia pritarimą, reiškia, kad šiems moduliams, greičiausiai, buvo atlikti reikiami kvalifikacijos bandymai ir jie atitiko griežtus našumo bei patikimumo reikalavimus. Tai suteikia ne tik finansinę naudą Samsung, bet ir techninį įvertinimą jų HBM3E platformai.

Palyginimai su konkurentais

Samsung vs SK Hynix vs Micron

Rinkoje dominuoja keli pagrindiniai žaidėjai su HBM3E gebėjimais. Kiekvienas turi savo stipriąsias puses:

- Samsung: akcentuoja gamybos mastą, aukštą talpą (36 GB HBM3E-12H) ir spartą diegti sprendimus, kai praeina kvalifikaciją.

- SK Hynix: taip pat gamina pažangią HBM atmintį ir gali pasiūlyti konkurencingą pralaidumą bei gero lygio paklausos aptarnavimą, priklausomai nuo gamybos pajėgumų.

- Micron: istorijoje kartais vėluoja arba laikosi atsargesnės pozicijos naujų HBM kartų masinei gamybai, tačiau turi stiprią R&D bazę ir gali pasiūlyti alternatyvas tam tikroms rinkos dalims.

Praktinė išvada: galutinė tiekėjo pasirinkimo nauda priklauso nuo kainos, prieinamumo, gamybos patikimumo ir nuo to, kaip gerai atminties modulis integruojamas į konkretų akceleratoriaus dizainą.

Ekspertų nuomonės ir rinkos vertinimai

Pramonės analitikai paprastai vertina tokio pobūdžio pranešimus atsargiai — jie pabrėžia, kad kol nėra oficialių patvirtinimų iš Samsung arba Nvidia, tai lieka nepriklausomu pranešimu, kurį reikėtų laikyti labiau indikacija nei galutiniu faktu. Tačiau jeigu sandoris bus patvirtintas, ekspertai tikisi kelių pasekmių:

- Trumpalaikė rinka gali sulaukti stabilumo ženklų dėl platesnio tiekėjo rato.

- Gamintojų konkurencija galėtų sumažinti HBM3E kainas arba priversti tiekėjus pasiūlyti geresnę tiekimo patikimumą.

- Debesų paslaugų teikėjai ir hyperscale centrai gali pasinaudoti didesne pasiūla ir spartesniu diegimu, greičiau atnaujindami serverių parkus.

Kainodara ir rinkos pozicionavimas

Konkretūs HBM3E kainų duomenys paprastai nėra viešai skelbiami ir priklauso nuo derybų tarp gamintojų bei klientų, užsakymo dydžio ir ilguoju laikotarpiu numatomų tiekimo įsipareigojimų. Didelis užsakymas, kaip 10 000 vienetų, gali sudaryti sąlygas geresnėms kainoms Samsung atžvilgiu, ypač jei sandoryje yra ilgalaikio tiekimo priemonių arba garantijų. Nvidia, kaip pagrindinis AI akceleratorių gamintojas, siekia tiek prixing efektyvumo, tiek tiekimo saugumo — tai dar labiau skatintų derybas apie kainodarą ir pristatymo terminus.

Praktinės pasekmės klientams (serverių operatoriams ir debesų paslaugoms)

Jei sandoris pasitvirtintų ir pristatymai vyktų pagal planą, serverių operatoriai galėtų gauti prieigą prie papildomos HBM3E atsargų, reiškiančių greitesnį naujų platformų diegimą. Tai ypač svarbu dideliems paslaugų teikėjams, kuriems reikalinga tiek pralaidumo, tiek talpos augimo galimybė AI darbo krūviams.

Taip pat svarbu paminėti, kad atminties modelio pasirinkimas turi įtakos ne tik našumui, bet ir energijos vartojimui, aušinimo reikalavimams bei galimybėms lengviau palaikyti sparčiai besikeičiančius AI modelių poreikius.

Išvados ir perspektyvos

Pranešimas apie Samsung ir Nvidia susitarimo galimybę iliustruoja, kaip atminties tiekimo grandinės tampa strateginiu resursu AI erdvėje. 10 000 vienetų užsakymas būtų reikšmingas pradinio dydžio krovinys, o vėlesnės užsakymų partijos galėtų būti didesnės, priklausomai nuo Nvidia akceleratorių linijų plėtros ir hyperscale duomenų centrų poreikio.

Samsung laimėjimas kaip tiekėjas reikštų ne tik papildomas pajamas, bet ir technologinį patvirtinimą, kad jų HBM3E sprendimai atitinka griežtus našumo ir patikimumo standartus. Tuo pačiu metu konkurencija tarp Samsung, SK Hynix ir Micron galėtų skatinti inovacijas, geresnį kainos-lengvumo santykį ir didesnį pasirinkimą serverių operatoriams.

Rekomendacijos pirkėjams ir infrastruktūros planuotojams

Serverių pirkėjams ir architektams, planuojantiems AI infrastruktūros atnaujinimus, svarbu sekti oficialius patvirtinimus iš tiekėjo ir užsakovų. Rekomendacijos:

- Vertinti tiekėjo diversifikaciją: pasikliauti vienu HBM tiekėju rizikinga; siekti daugiau nei vieno patikimo tiekėjo.

- Planuoti talpos ir pralaidumo poreikį pagal konkrečius modelių reikalavimus: 36 GB HBM3E kaupikliai suteikia didelę naudingą talpą tokiems darbams kaip LLM treniravimas.

- Atlikti suderinamumo testus su planuojamais akceleratoriais: realūs darbo krūviai gali atskleisti papildomas integracijos ar aušinimo problemas.

- Sverti kainos ir pristatymo garantijas: ilgalaikiai kontraktai gali suteikti stabilumą ir geresnes kainas, bet reikalauja rūpestingo tiekėjo rizikos vertinimo.

Papildomi pastabos ir šaltiniai

Nors pagrindinis pranešimo šaltinis yra AlphaBiz, iki tol, kol Samsung arba Nvidia pateiks oficialų pranešimą, rekomenduojama manyti, kad informacija yra preliminari. Techniniai duomenys apie HBM3E-12H (36 GB, ~1 280 GB/s) yra baziniai parametrai, kuriuos gamintojai viešai pristatė anksčiau; praktinis našumas gali skirtis priklausomai nuo integracijos ir sistemos architektūros.

Galutinės mintys

Pranešimas apie Samsung laimėtą 10 000 HBM3E modulių užsakymą yra reikšmingas indikatorius apie tai, kad atminties tiekėjų konkurencija ir techninis suderinamumas tampa vis svarbesni AI infrastruktūros ekosistemoje. Jei sandoris bus patvirtintas ir pristatymai vyks laiku, tai gali turėti teigiamą poveikį tiek Samsung pozicijoms rinkoje, tiek Nvidia tiekimo saugumui. Serverių operatoriams ir debesų paslaugų teikėjams verta stebėti oficialius pranešimus, testuoti HBM3E integracijas ir planuoti tiekimo grandinę atsižvelgiant į galimus tiekėjo pasikeitimus.

Santrauka: HBM3E yra kertinė technologija moderniems AI akceleratoriams. 36 GB HBM3E-12H moduliai su ~1 280 GB/s pralaidumu suteikia reikšmingą našumo pagerinimą ten, kur atminties pralaidumas yra tokia pati svarba kaip ir grynas skaičiavimo pajėgumas. Samsung galimas laimėjimas prieš Nvidia — jei pasitvirtins — būtų ženklas, kad įmonės technologinis tobulėjimas atitinka didžiausių AI infrastruktūros pirkėjų reikalavimus.

Šaltinis: sammobile

Palikite komentarą