8 Minutės

Netikėtas atradimas bendrame Merilando universiteto ir Microsoft tyrime: lenkų kalba pasirodė veiksmingiausia kalba pateikiant komandas dideliems dirbtinio intelekto modeliams, lenkdama 25 kitas kalbas, tuo tarpu anglų kalba užėmė tik šeštą vietą.

Kaip tyrėjai vertino kalbų našumą su DI modeliais

Tyrėjų komanda vienodas užduočių užklausas (promptus) išvertė į 26 kalbas ir pateikė jas keliems dideliems kalbos modeliams — įskaitant OpenAI modelius, Google Gemini, Qwen, Llama ir DeepSeek — siekdama pamatuoti užduočių tikslumą. Priešingai lūkesčiams, lenkų kalba pasirodė geriausiai: vidutinis užduočių tikslumas buvo 88 %.

Ataskaitos autoriai pavadino rezultatus „nenumatytais“ ir pažymėjo, kad anglų kalba nėra akivaizdus nugalėtojas visais atvejais. Vertinant ilgesnius tekstus, anglų kalba užėmė šeštą vietą, o lenkų kalba buvo geriausia. Šie rezultatai akcentuoja, kad kalbos pasirinkimas gali reikšmingai paveikti modelio atsakymų kokybę ir patikimumą.

Tyrimo lyderių sąrašas — geriausiai veikiančios kalbos

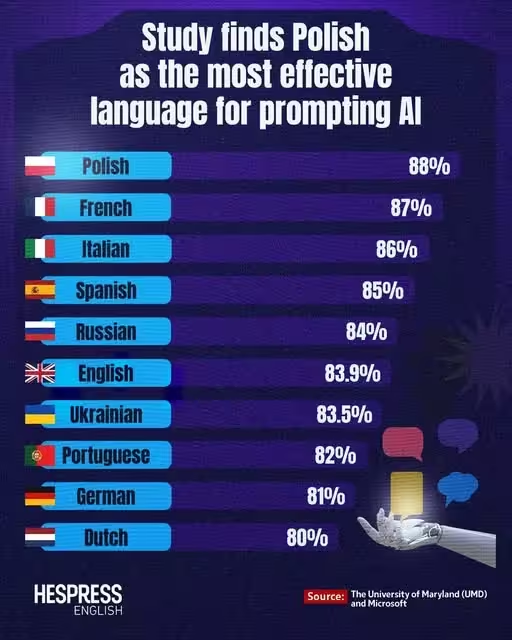

Žemiau pateikiamas dešimtukas kalbų, surikiuotų pagal vidutinį tikslumą tyrime:

- Lenkų — 88%

- Prancūzų — 87%

- Italų — 86%

- Ispanų — 85%

- Rusų — 84%

- Anglų — 83.9%

- Ukrainiečių — 83.5%

- Portugalų — 82%

- Vokiečių — 81%

- Olandų — 80%

Kodėl lenkų kalba gali būti geresnė komandų pateikimui?

Yra keletas teorijų, kurios gali paaiškinti šį paradoksalų reiškinį. Pirmiausia, lenkų kalba yra morfologiškai turtinga: žodžių linkimai ir galūnės suteikia daug gramatinių signalų. Tokia struktūra gali generuoti žodžių dalis (tokenus), kurie geriau sutampa su transformerių naudojamomis tokenizavimo schemomis (pavyzdžiui, byte-pair encoding, WordPiece ar SentencePiece). Kai tokenizacija atitinka lingvistinę struktūrą, modelis gali gauti aiškesnę komandą net ir turint mažiau treniravimo pavyzdžių lenkų kalba.

Antra, tam tikros kalbos priverčia išreikšti gramatinius santykius labiau aiškiai nei kitos. Kai kalba „priverčia“ nurodyti tarinį, linksnius ar kitus morfologinius elementus, sumažėja netikslumų rizika, kad modelis neteisingai supras užklausos intenciją. Trumpai tariant, mažesnė dviprasmybė sintaksėje ir morfologijoje gali pagerinti modelio supratimą ir atsakymų tikslumą.

Tyrimas taip pat pabrėžia, kad kalbos „sunkumas“ žmonėms nebūtinai reiškia sudėtingumą modeliams: neuroniniai tinklai gali išmokti struktūrinius šablonus nepriklausomai nuo to, ar kalbą lengva įsisavinti žmogui. Jei tokenizavimo žodynas (vocabulary) arba subžodžių padalijimai atitinka morfologinius vienetus, tai gali suteikti pranašumą net ir esant mažesniam kiekiui lenkiškų tekstų mokymuisi.

Be to, kalbos normalizavimo ir teksto paruošimo priemonės (preprocessing) — pavyzdžiui, diakritinių ženklų tvarkymas, daugtaškių bei specialių simbolių normalizavimas — gali turėti reikšmės. Kai kurių kalbų tekstuose mažiau reikšmingų formų arba aiškesnė gramatinė struktūra leidžia sukurti „švaresnį“ įvesties signalą modeliams.

Visgi verta paminėti ir atvirkštinį pavyzdį: kinų kalba šioje lentelėje atsidūrė tarp žemesniųjų (ketvirta nuo galo), nors daugeliui modelių yra pasiekiamas didelis kiekis kinų kalbos duomenų. Tai rodo, kad didelis treniravimo duomenų kiekis vien per save negarantuoja geresnių rezultatų užduočių pritaikyme – svarbūs ir tokenizacijos metodai, simbolių atvaizdavimas, bei konkretūs užduočių formatai.

Techniniai veiksniai: tokenizacija, morfologija ir duomenų pasiskirstymas

Norint suprasti, kodėl tam tikros kalbos duoda geresnius rezultatus, verta giliau pažvelgti į kelis techninius elementus:

- Tokenizavimo schema: dauguma didelių kalbos modelių naudoja subžodžių tokenizaciją (BPE, WordPiece, SentencePiece). Kai kalba turi daug afiksų, vienos tokenizacijos strategijos gali natūraliai išskaidyti morfologines vienetus, kurie yra prasmingi modelio statistikai.

- Žodyno dydis ir universalumas: didelis žodynas, apimantis daug formas, gali pagerinti aprėptį, bet taip pat padidinti sparsity (retų tokenų reiškinį). Kai kurioms kalboms geresnis sprendimas yra mažesni, bet morfologiškai sąmoningi tokenai.

- Kryžminis žinių pernešimas (cross-lingual transfer): modeliai, išmokyti daugiakalbiuose korpusuose, gali perkelti žinias tarp gimininių kalbų. Pavyzdžiui, geros performanso prancūzų ir ispanų kalbose gali padėti artimai susijusioms kalboms, tačiau tai neprivalo paaiškinti lenkų dominavimo, nes lenkų nėra tiesiogiai artima romanų kalboms.

- Duomenų kokybė ir žanrai: jei treniravimo duomenyse lenkiški tekstai yra pritaikyti instruktavimui arba turi daug techninių ir aiškių paaiškinimų, modelis gali geriau išmokti reaguoti į komandų formato tekstus lenkų kalba.

Tokenizacijos tipai ir jų poveikis

Trumpai apie konkrečias tokenizacijos technologijas: BPE (byte-pair encoding) suskaido žodžius į dažniausiai sutampančius simbolių porų blokus, WordPiece kuria žodyno vektorius optimizuodamas tikimybę, o SentencePiece dirba tiesiogiai su baitų sekų reprezentacija ir tinka kalboms, kuriose nėra aiškios žodžių ribos. Kiekviena iš šių strategijų gali skirtingai elgtis su morfologiškai turtingomis kalbomis. Pavyzdžiui, lenkų papildomi galūnių tokenai gali būti stabiliai reprezentuojami, o tai leidžia modeliams „juos pamatyti“ dažniau kaip atskirus prasmingus vienetus.

Promptų inžinerijos ir daugakalbio DI implikacijos

Ką turėtų iš šio tyrimo pasimokyti vystytojai, tyrėjai ir promptų inžinieriai?

- Nesilaikykite prielaidos, kad anglų kalba visada geriausia: testuokite promptus keliomis kalbomis — gali atsitikti taip, kad netikėta kalba duos tikslesnius, aiškesnius ar trumpesnius atsakymus.

- Atsižvelkite į morfologiją ir tokenizaciją: kuriant daugakalbius etalonus (benchmarks) arba ruošiant fine-tuning duomenų rinkinius, svarbu įvertinti, kaip tokenizacija atvaizduoja kalbinę struktūrą.

- Vertinkite modelio elgesį tikslinėse kalbose: tarptautiniuose diegimuose nereikėtų ekstrapoliuoti iš anglų kalbos testų elgesio; būtina patikrinti kiekvieną tikslinę kalbą.

Lenkijos patentų biuras netgi socialiniuose tinkluose pažymėjo, kad rezultatai rodo: lenkų kalba yra pati tiksliausia kalba nurodymams DI, pridėdamas ironijos pastabą: žmonėms lenkų kalba gali atrodyti sunki, bet DI tokios problemos neturi.

Praktiniai rekomendacijos promptų kūrėjams

Remiantis tyrimo įžvalgomis, pateikiu keletą praktinių žingsnių techniniams specialistams ir produktų komandoms:

- Pradėkite nuo A/B testų: paruoškite identiškas užduotis keliomis kalbomis ir palyginkite atsakymų tikslumą, aiškumą bei glaustumą.

- Analizuokite tokenizaciją: pasinaudokite įrankiais, leidžiančiais pamatyti, kaip jūsų promptas suskaidomas į tokenus (pvz., modelių tokenizatoriai). Jei pastebite, kad svarbūs žodžiai išsiskaido nepalankiai, apsvarstykite alternatyvų formulavimą arba subžodžių derinimą.

- Pasirūpinkite duomenų kokybe fine-tuning metu: įtraukite instruktines, aiškias ir įvairių stilių užklausas, tam kad modelis išmoktų reaguoti į komandų formą.

- Įtraukite lingvistų komandas: kai kuriems projektams naudingas kalbininkų indėlis vertinant dviprasmiškumą, morfologinius aspektus ir vertimo priemonių poveikį.

Verslo ir produktų perspektyvos

Įmonės diegdamos daugakalbius sprendimus turėtų planuoti resursus kalbų testavimui ir optimizavimui. Pavyzdžiui, vartotojo sąsajos (UI) lokalizacija, paieškos užklausų supratimas (NLP) ar automatizuotos pagalbos sistemos (chatbot) gali pagerėti, jei testavimas atliekamas ne tik anglų, bet ir kitomis prioritetinėmis kalbomis. Tokiu būdu sumažinama rizika, kad anglų kalba suteiks iliuzinį patikimumą, o realiame vartojime atsiskleis netikslumai.

Ką reikėtų tyrinėti toliau?

Tyrėjai sako, kad tai nėra paskutinis žodis šiuo klausimu — reikia daugiau darbo, kad suprastume, kaip tokenizacija, treniravimo duomenų pasiskirstymas ir lingvistinė struktūra veikia modelio elgseną. Štai keletas konkrečių kryptių tolesniems tyrimams:

- Kontroliuoti tokenizacijos eksperimentai: bandyti tas pačias užduotis su skirtingomis tokenizavimo schemomis, kad aiškiai išskirti tokenizacijos poveikį.

- Duomenų kokybės analizė: įvertinti, kokio tipo lenkiški tekstai dominuoja treniravimo duomenyse ir ar jie turi instruavimo pobūdį.

- Kalbų grupių palyginimai: šiame tyrime lenkų pranašumas galėjo būti susijęs su konkrečiomis savybėmis — verta palyginti panašias slavų kalbas arba morfologiškai turtingas neoindoeuropietiškas kalbas.

- Konteksto ir ilgio poveikis: patikrinti, kaip komandų ilgio ir konteksto struktūra skirtingose kalbose keičia modelio atsakymų kokybę.

Tyrimas skatina DI bendruomenę iš naujo įvertinti prielaidas ir plačiai eksperimentuoti optimizuojant promptus daugakalbiams modeliams. Tai taip pat reikalauja skaidresnės metrikos ir standartų kūrimo, kad būtų galima lyginti rezultatus tarp kalbų ir modelių.

Apibendrinimas ir praktinė reikšmė

Nors rezultatai gali nustebinti, jie nepaneigia anglų kalbos svarbos — dauguma modelių yra intensyviai mokyti anglų kalba ir dažnai veikia puikiai. Vis dėlto tyrimas primena, kad pasirinkimas, kokia kalba pateikiate užklausą, gali būti strateginis sprendimas, turintis įtakos atsakymo tikslumui, nuoseklumui ir glaustumui. Dėl to produktų komandos, mokslininkai ir inžinieriai turėtų įtraukti kalbų testavimą į savo darbo eigą, analizuoti tokenizacijos įtaką ir apsvarstyti morfologiją kaip vieną iš kintamųjų, formuojančių modelio elgesį.

Galiausiai, šis tyrimas atveria platesnę diskusiją apie tai, kaip kalbinės savybės sąveikauja su mašininio mokymosi architektūromis. Praktinė žinia — nebijokite eksperimentuoti su neįprastomis kalbomis: jos gali atskleisti pranašumus, kurių neaptinka tradiciniai anglų kalbos orientuoti testai.

Šaltinis: smarti

Komentarai

tyrejas

Rimtai? Neužtenka tik 26 kalbų bandymo. Reikėtų kontroliuotų eksperimentų su skirtinga tokenizacija ir duomenų profiliu. Dar daug klaustukų...

Tomas

Wow, netikėta! Lenkų kalba geriausia komandoms? Skamba keistai, bet labai įdomu. Ar tai tik tokenizacijos efektas, ar dar kažkas?

Palikite komentarą