3 Minutės

Huawei, kaip pranešama, kuria dirbtiniam intelektui optimizuotą SSD, kad konkuruotų su HBM

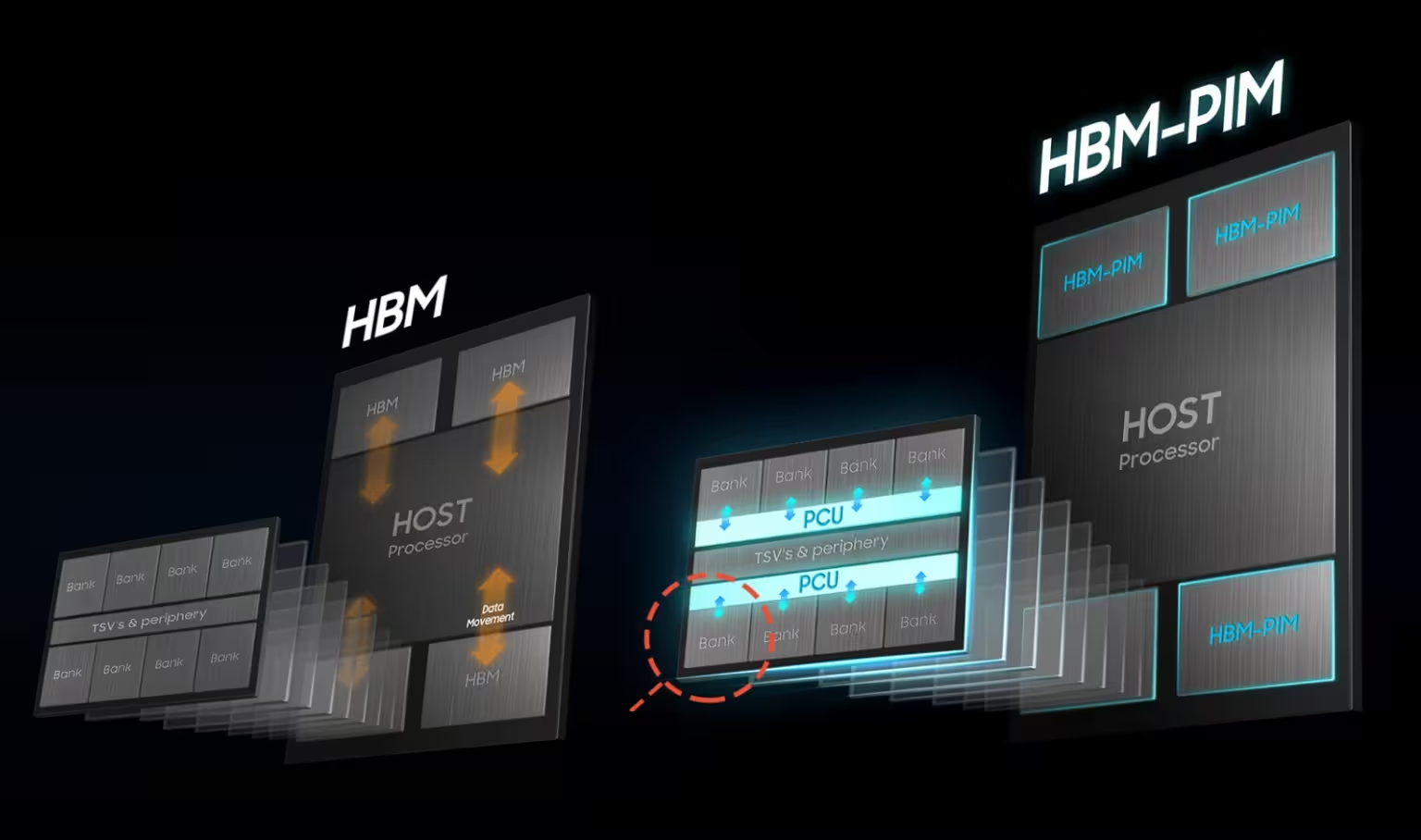

Kinijos žiniasklaidos pranešimai teigia, kad Huawei kuria specializuotą „AI atmintį“ — apibūdinamą kaip kietojo kūno diską (SSD), pritaikytą duomenų centrų dirbtinio intelekto darbo krūvėms. Esą šis AI SSD turėtų suteikti HBM panašų pralaidumą ir efektyvumą, tuo pačiu pašalinant tradicinius talpos apribojimus, taip potencialiai siūlydamas praktinę alternatyvą aukštos pralaidumo atminčiai (HBM) ir mažinant Huawei priklausomybę nuo Vakarų tiekimo grandinių.

Produkto ypatybės: ką turėtų pasiūlyti AI SSD

Išplečiama talpa be griežtų apribojimų

Pasak pranešimų, AI SSD siekia panaikinti siaurus HBM pakelių talpos ribojimus, leidžiant kur kas didesnius efektyvius atminties baseinus dideliems kalbos modeliams (LLM) treniruoti ir inferencijai.

Duomenų centro optimizavimas ir efektyvumas

Teigiama, kad įrenginys yra optimizuotas AI specifiniams prieigos modeliams, pirmenybę teikiant mažai latencijai, dideliam pralaidumui ir ištvermės profilams, pritaikytiems intensyvioms treniruotėms — savybėms, kurios jį išskiria iš įprasto NVMe SSD.

Programinė pusė: UCM (vieningas talpyklos valdytojas) ir atminties orkestracija

Be aparatūros darbų, Huawei pristatė Unified Cache Manager (UCM) programinę įrangą, sukurtą spartinti LLM treniravimą sujungiant HBM, DRAM ir SSD išteklius. UCM gali skaidriai sluoksniuoti ir talpinti tensorius per skirtingas atminties rūšis, išplėsdama prieinamą atmintį AI darbo krūvėms net tuomet, kai aukštos pralaidumo moduliai yra riboti.

Palyginimai: AI SSD vs HBM, DRAM ir tradiciniai SSD

HBM vis dar neprilygsta su grubiu pralaidumu vienam vatui ir glaudžiu GPU/akceleratoriaus artumu, tačiau ji yra brangi ir geopolitiniu požiūriu jautri. Tradicinė DRAM suteikia mažesnę latenciją nei SSD, bet ribojama kainos ir talpos mastelio. AI SSD žada viduriniąją poziciją: daug didesnę talpą nei HBM už mažesnę kainą, pagerintą pralaidumą AI prieigos modeliams palyginti su įprastais SSD ir sklandžią integraciją per programinę įrangą, tokią kaip UCM.

Privalumai, naudojimo scenarijai ir rinkos reikšmė

Privalumai apima tiekimo grandinės atsparumą, didesnę talpą LLM modeliams ir galimą kaštų sumažinimą hyperscaler'iams bei debesų paslaugų tiekėjams. Naudojimo scenarijai apima plataus masto modelių treniravimą, paskirstytas inferencines klasteres ir duomenų centro atminties bendrinimą. Strategiškai, gyvybingas AI SSD galėtų padėti Kinijos DI aparatūros ekosistemoms sumažinti atotrūkį nuo lyderių, tokių kaip NVIDIA, siūlant alternatyvias atminties hierarchijas esant eksporto apribojimams.

Įspėjimai ir perspektyvos

Architektūros, vėlavimo statistikos ir realaus pasaulio bandomųjų rezultatų detalės išlieka neatskleistos. Teiginiai apie talpos apribojimų panaikinimą ir HBM efektyvumo pasiekimą reikalauja nepriklausomo patvirtinimo. Vis dėlto Huawei kombinuotas aparatūros ir programinės įrangos požiūris — AI SSD kartu su UCM — rodo pragmatišką kelią, kaip išplėsti DI atmintį politinių ir geopolitinių apribojimų sąlygomis.

Šaltinis: wccftech

Komentarai