8 Minutės

OpenAI pristatė GPT-5-Codex-Mini, kompaktišką ir biudžetui draugišką savo GPT-5 pagrįsto Codex programavimo modelio versiją, sukurta suteikti programuotojams prieinamą prieigą prie pažangaus kodo generavimo ir programinės įrangos inžinerijos pagalbos. Ši nauja alternatyva orientuota į komercinius ir atviro kodo projektus, kur svarbu išlaikyti aukštą našumą ir kartu kontroliuoti debesijos ir skaičiavimo išlaidas.

Ką siūlo naujas mini modelis

GPT-5-Codex-Mini yra mažesnė, kaštams optimizuota GPT-5-Codex versija. Jos tikslas – pristatyti pagrindines kodo generavimo ir programavimo pagalbos galimybes: naujų projektų inicializavimą, funkcijų ir testų pridėjimą, didelio masto refaktoringą bei kodo peržiūras. Tuo pačiu siekiama sumažinti skaičiavimo sąnaudas, kad komandos galėtų atlikti kur kas daugiau užduočių už tą pačią biudžeto sumą.

Praktikoje OpenAI teigia, kad Mini modelis leidžia maždaug keturis kartus padidinti naudojimo apimtis, palyginti su pilna GPT-5-Codex versija, atiduodamas tik nedidelį tikslumo ir loginio mąstymo „nuosmukį“. Tai reiškia, jog dauguma rutininių automatizuotų užduočių – kodo šablonų generavimas, standartinių funkcijų įgyvendinimas, testų rašymas ir paprasti refaktoringo veiksmatai – gali būti atliktos pigesne, bet vis dar patikima priemone.

Vertinant iš produktinio taikymo perspektyvos, Mini tampa patraukliu pasirinkimu komandoms, kurios turi didelius apimties poreikius: CI/CD testų generavimas, kodų analizė, dokumentacijos atnaujinimas ir kitų žemo rizikos automatizuotų darbo eigos dalių perėmimas. Tuo pačiu, žinant gedimų arba išimčių riziką, aukštesnės rizikos arba kritinius uždavinius visada rekomenduojama palikti pilnai GPT-5-Codex ar aukštesnio lygio modeliams.

Kaip sekasi: realūs benchmarkų rezultatai

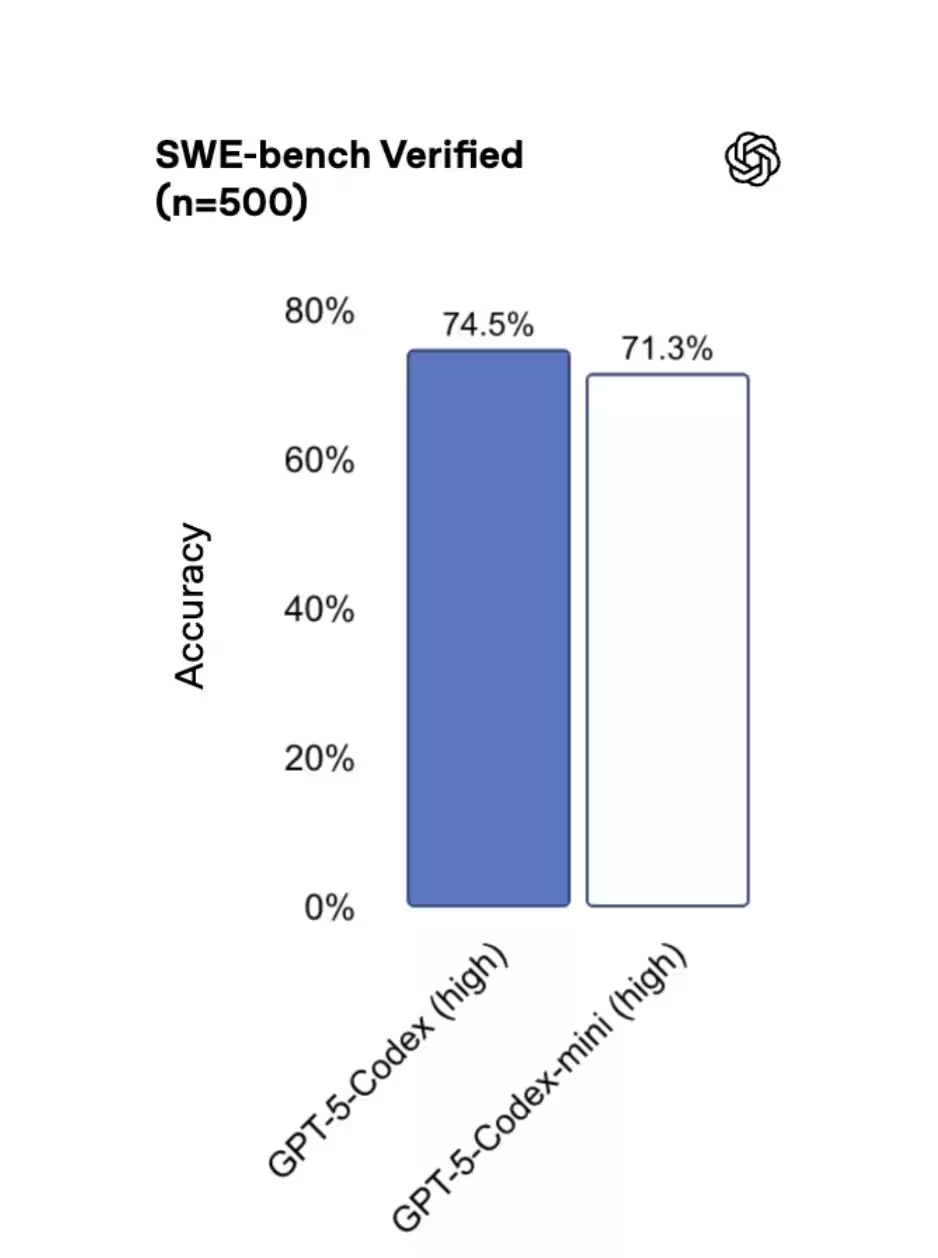

SWE-bench Verified etaloniniai testai rodo, kad trijų modelių rezultatai yra gana arti vienas kito: GPT-5 High surinko 72,8 %, GPT-5-Codex — 74,5 %, o GPT-5-Codex-Mini užfiksavo 71,3 %. Šie skaičiai leidžia daryti prielaidą, kad Mini išlaiko daugeliu atvejų pagrindinius originalaus modelio privalumus, kartu suteikdama reikšmingą kaštų taupymą — tai yra patrauklus kompromisas daugeliui gamybinių srautų ir automatizacijos scenarijų.

Reikia atkreipti dėmesį į tai, kaip vertinami benchmarkai ir ką jie reiškia realioms darbo sąlygoms. Benchmarkų pakopos (angl. tiers) dažnai konkretizuojamos pagal užduočių tipą: vienur vertinama sintaksės ir API supratimo atitikimo tikslumas, kitur — algoritminio mąstymo ir kelių žingsnių problemų sprendimo kokybė. Mini modelis dažniausiai praranda šiek tiek taškų sudėtingesniuose, daugiapakopiuose uždaviniuose, tačiau išlaiko stiprų našumą vieno žingsnio arba šabloninių užduočių generavime.

Praktiniai testai programinės įrangos inžinerijoje rodo, jog investuojant į modelio pasirinkimą pagal užduočių profilį galima optimizuoti išlaidas: taikant Mini generuoti testams, kodo šablonams ir rutininei refaktorizacijai, o svarbiausias logiką ar saugumo reikalaujančias užduotis nukreipiant į aukštesnės klasės modelius, galima pasiekti gerą našumo ir kaštų balansą.

Kada programuotojai turėtų rinktis Mini

Kada Mini yra tinkamiausias sprendimas? OpenAI rekomenduoja naudoti GPT-5-Codex-Mini lengvesnėms inžinerinėms užduotims arba kaip atsarginį variantą, artėjant pagrindinio modelio naudojimo limitams. Codex įrankiai netgi siūlo pereiti prie Mini, kai pasiekiami maždaug 90 % kvotos. Tokiu būdu Mini veikia kaip „duslintuvas“ arba „throttle“ – kritinius, aukštos rizikos darbus palikite pilnam modeliui, o rutininį arba didelio apimties darbą perkelkite į Mini, kad ištemptumėte biudžetą ir didintumėte pralaidumą.

Konkrečios scenarijos, kur Mini yra ypač naudingas:

• Automatizuotos testų generavimo ir pradinės kodo paraiškos kūrimo operacijos, kur galimas minimalus koregavimas po generavimo;

• Didelio tūrio kodo peržiūros ir analitinės užduotys, reikalaujančios mažesnio semantinio tikslumo, bet didelio greičio;

• CI/CD žingsniai, kur greitas atsakas ir mažesnės sąnaudos yra svarbesni nei maksimalus konteksto gylis;

• Tarpinis sluoksnis, kai reikia apdoroti didelius duomenų kiekius arba sujungti daugybę šabloninių transformacijų.

Tačiau verta paminėti, kad Mini nėra skirtas pakeisti aukščiausio lygio modelius, kai reikalaujama griežto saugumo patikrinimo, sudėtingų architektūrinių sprendimų ar teisinės bei reguliacinės atitikties vertinimo. Tokiais atvejais geriau naudoti aukštesnės klasės modelius arba hibridinius procesus, kombinuojančius modelį su žmogaus peržiūra.

Kur galite jį naudoti šiandien

Mini jau prieinamas Command Line Interface (CLI) ir kaip IDE plėtinys (IDE plugin), o API palaikymas pažadėtas artimiausiu metu. Tai leidžia programuotojams integruoti Mini į vietinius darbo srautus, CI vamzdynus ir redaktorių valdomas kodavimo sesijas iš karto — dar prieš platesnę API prieinamybę.

Praktiškai tai reiškia, kad kūrėjai gali:

• Integruoti GPT-5-Codex-Mini į savo lokalias plėtros aplinkas per CLI komandą, automatizuojant rutininius uždavinius ir generuojant kodo šablonus tiesiai vietiniame aplinkoje;

• Naudoti IDE plėtinius, kurie padeda rašyti funkcijas, kurių sintaksė arba API kvietimai yra standartiniai, taip sumažinant laiko sąnaudas rašant pasikartojantį kodą;

• Paruošti CI/CD žingsnius, kuriuose Mini generuoja testinius failus, mock'us ar paprastas perrašymo taisykles prieš paleidžiant pilną testų rinkinį su aukštesnio lygio įrankiais.

Tokia prieinamumo strategija leidžia pritaikyti Mini tiek mažoms komandoms, tiek didelėms įmonėms — ypač tiems, kuriems svarbu palaikyti greitą iteraciją ir kontroliuoti debesijos sąnaudas. Kai API galutinai bus plačiai prieinama, integracijos galimybės padidės: server-side automatizacija, platforminių paslaugų sujungimas ir paskirstyti darbo krūviai taps dar paprastesni.

Užkulisiuose: našumo ir patikimumo patobulinimai

OpenAI taip pat paskelbė infrastruktūros patobulinimus, siekiant padaryti Codex naudojimą labiau nuspėjamą. GPU efektyvumo optimizacijos ir maršrutizavimo patobulinimai leido OpenAI padidinti užklausų dažnio limitus (rate limits) 50 % ChatGPT Plus, Business ir Education abonentams. Pro ir Enterprise klientai gauna prioritetinį apdorojimą, kad būtų išlaikytas didžiausias greitis ir reagavimo laikas.

Anksčiau buvusios problemos, susijusios su talpinimo (caching) klaidomis, kurios laikinai mažino naudingą pajėgumą, buvo pašalintos, todėl programuotojai turėtų pastebėti stabilesnę ir patikimesnę patirtį visos dienos metu. Tai ypač svarbu gamybiniuose režimuose, kur svyravimai gali nulemti vėlavimus pipeline'uose arba papildomas išlaidas dėl pakartotinių užklausų.

Techninės detalės, kurios prisidėjo prie patobulinimų:

• GPU našumo optimizavimas: efektyvesnis atminties panaudojimas ir užduočių pakavimas (batching) leidžia aptarnauti daugiau užklausų vienu metu, taip mažinant vėlavimus ir kaštus;

• Maršrutizavimo patobulinimai: dinaminis užklausų nukreipimas ir prioritetų valdymas, kuris užtikrina, kad Pro/Enterprise kliento užklausos gautų geresnę garantuotą kapaciteto dalį;

• Talpyklos ir resurso valdymas: klaidų taisymas talpyklos logikoje, kuris užkerta kelią netikėtam resursų „užšalimui“ ir garantuoja nuoseklesnį aptarnavimo lygį.

Be to, OpenAI toliau stiprina monitoringą ir telemetriją, kad greičiau identifikuotų veikimo „butelio kaklelius“ (bottlenecks) ir galėtų skubiai pritaikyti pataisas. Tai reiškia, jog programavimo modelių integracijai į gamybinę veiklą reikėtų skirti dėmesio telemetriniams duomenims: atsako laikui, klaidų dažniui ir modelio produktyvumui pagal skirtingus operacijų tipus.

Apskritai: GPT-5-Codex-Mini suteikia komandoms praktišką būdą išplėsti kodo automatizavimą be proporcingo kaštų didėjimo. Daugeliui programuotojų tai bus protingesnis pasirinkimas didelio tūrio arba mažesnės rizikos užduotims — ypač kol OpenAI tęsia API plėtrą ir gerina našumo garantijas. Įmonės, kurios tinkamai derins Mini su aukštesnės klasės modeliais ir žmogaus peržiūros mechanizmais, gali pasiekti didesnį automatizacijos efektyvumą, greitesnę iteraciją ir geresnę kaštų kontrolę.

Praktiniai patarimai diegimui:

• Sukurkite hibridinę strategiją: naudokite Mini didelio tūrio užduotims ir pilnus modelius kritiniams veiksmams;

• Stebėkite telemetrinius rodiklius: atsako laiką, klaidų dažnį ir sugeneruoto kodo kokybę skirtinguose scenarijuose;

• Nustatykite kokybės kontrolės taisykles: automatinė testavimo seka po modelio sugeneruoto kodo ir žmogaus peržiūra kritiniuose atvejuose;

• Palaikykite lankstų kvotų valdymą: automatinis perjungimas į Mini, kai pagrindinio modelio kvota arti viršutinės ribos.

Galiausiai, kaip su kiekvienu AI įrankiu, svarbu atsiminti, kad modeliai yra pagalbinės priemonės, o ne visiškai autonomiški sprendimai. Geriausi rezultatai pasiekiami integravus technologiją į gerai apibrėžtas darbo eigos nuostatas, kurios apima tiek automatizacijos naudą, tiek žmogaus kompetenciją priežiūrai ir sprendimų patvirtinimui.

Šaltinis: smarti

Komentarai

kodasx

Skamba per gerai: 4x naudojimo? Na, reikia realių pavyzdžių ir testų produkcijoj kol tikėsiu.

Tomas

Wow, ne tokio laukiau, bet vis tiek solidu. Įdomu kiek laiko realiai sutaupysim su legacy kodu... Hm

Palikite komentarą