7 Minutės

Įžanga

„Apple“ tyrimų komanda uždavė paprastą, bet neraminantį klausimą: ko realūs žmonės iš tiesų laukia iš dirbtinio intelekto (AI) agentų, kai šie padeda kasdienėse užduotyse? Atsakymas nėra tvarkingas. Jis yra niūrus, žmogiškas ir pilnas kompromisų. Šis straipsnis nagrinėja tyrimo išvadas, metodiką ir praktines rekomendacijas, kaip kurti AI agentų vartotojo sąsajas, kurios būtų aiškios, valdomos ir patikimos.

Tyrimo apžvalga

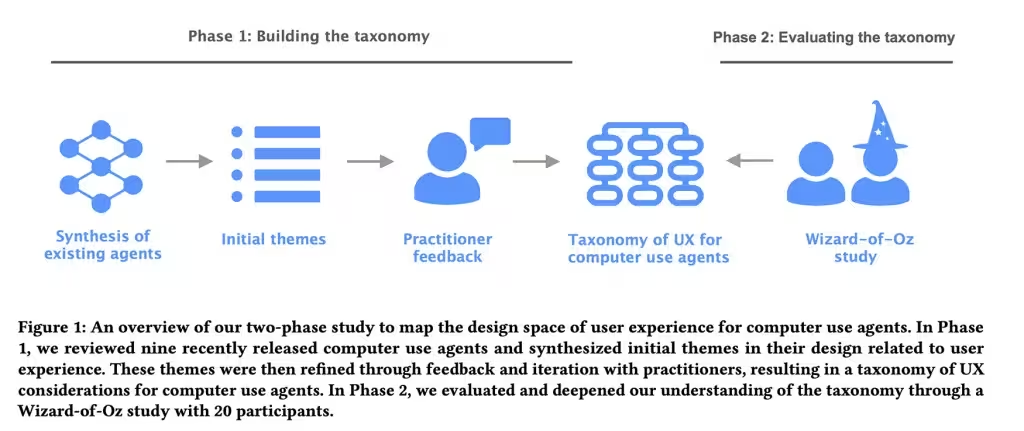

Dokumente pavadinimu Mapping the Design Space of User Experience for Computer Use Agents (liet. Kompiuterinių naudojimosi agentų vartotojo patirties dizaino erdvės žemėlapis) tyrėjai išanalizavo devynis esamus agentus — tokius pavadinimus kaip Claude Computer Use Tool, Adept, OpenAI Operator, AIlice, Magentic-UI, UI-TARS, Project Mariner, TaxyAI ir AutoGLM — siekdami žemėlapiu užfiksuoti, kaip šios sistemos pateikia galimybes, tvarko klaidas ir kviečia vartotojo kontrolę. Pirmojo etapo metu aštuoni UX ir AI specialistai atliko stebėjamąją ir klasifikavimo analizę: jie suskirstė kraštovaizdį į keturias pagrindines kategorijas, 21 poskyrį ir 55 konkrečias dizaino savybes. Jos apėmė visa, nuo to, kaip vartotojai perduoda įvestį agentui, iki to, kiek skaidrios yra agento veiksmai, kokią kontrolę vartotojas išlaiko ir kaip formuojami mentaliniai modeliai bei lūkesčiai.

Metodika: klasifikacija ir eksperimentas

Klasifikavimo fazė

Pirmas tyrimo etapas buvo sisteminis apžynimas ir klasifikacija. Specialistai identifikavo keturias pagrindines sritis, kurios apibrėžia vartotojo sąveiką su AI agentais: įvesties mechanizmai (kaip vartotojas perduoda nurodymus), veiksmų skaidrumas (kaip aiškiai agentas rodo ketinimus ir pažangą), klaidų valdymas (kaip agentas atpažįsta ir tvarko klaidas) ir kontrolės taškai (kur ir kaip vartotojas gali stabdyti ar koreguoti agentą). Kiekvienoje srityje išskirtos poskyriai ir ensuite — praktiškos dizaino savybės, kurias galima pritaikyti ir testuoti realiuose produktuose.

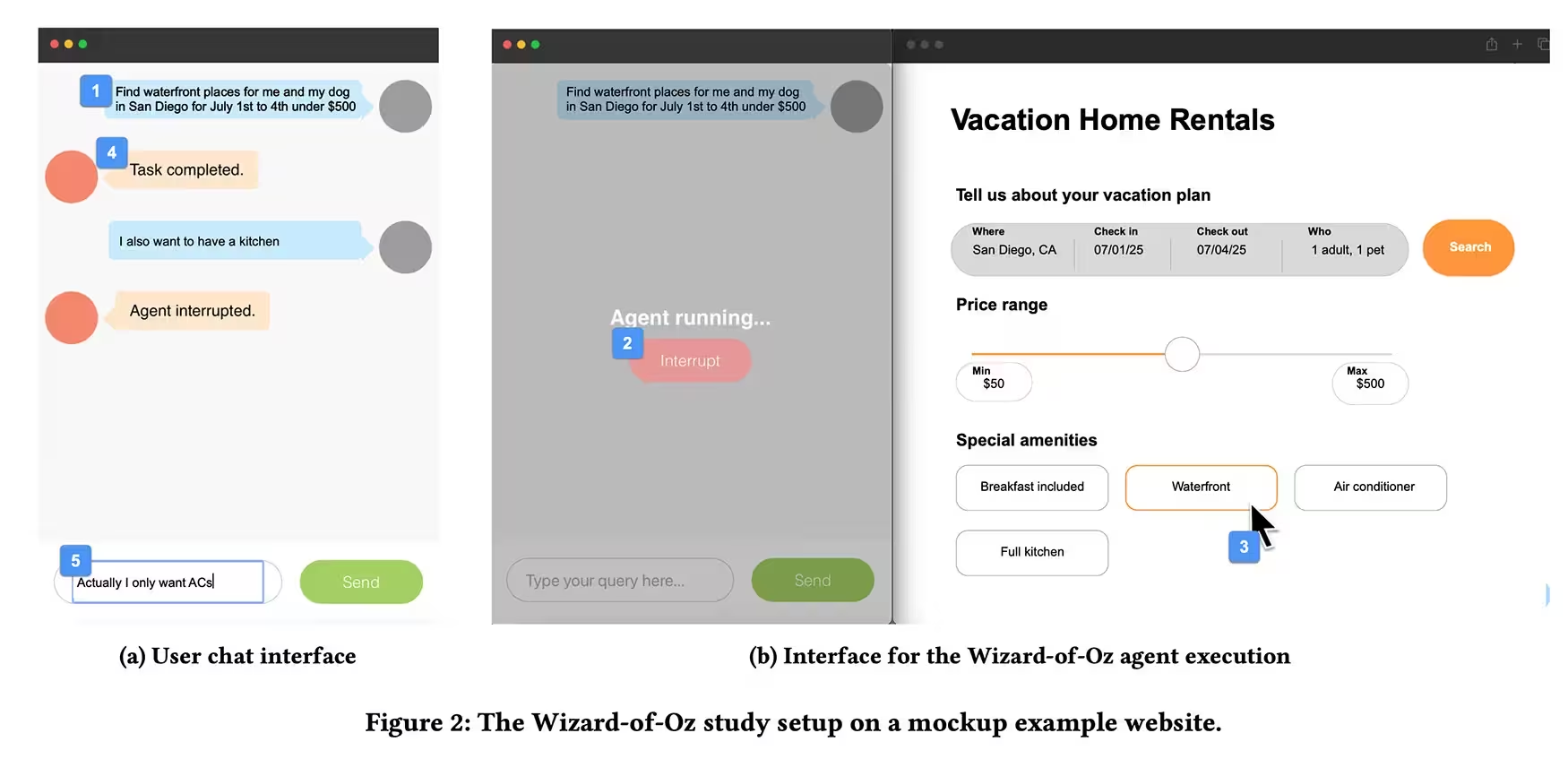

Wizard of Oz eksperimentas

Antrąjį etapą sudarė taip vadinamas „Oz burtininko“ eksperimentas: dvidešimt dalyvių, turinčių ankstesnės patirties su AI asistentais, buvo paprašyti deleguoti užduotis — pavyzdžiui, užsakymo atostogų ar prekių pirkimo internetu — per pokalbių tipo sąsają, tuo tarpu tyrėjas nematomas atliko agento funkcijas klaviatūra ir pele. Dalyviai galėjo įvesti komandų tekstą ir paspausti mygtuką stabdyti, kad nutrauktų agento veiksmą. Kai kurios užduotys buvo tyčia sabotuotos — pateiktos klaidos arba netikėti pertrūkimai — siekiant stebėti, kaip žmonės reaguoja, kai agentas suklysta arba daro prielaidas.

Pagrindinės išvados

Iš eksperimentų išryškėjo aiškus modelis: žmonės nori matyti, ką agentas daro, tačiau jie nenori detalizuoti kiekvieno paspaudimo ar sprendimo. Trumpi demonstratyvūs veiksmai ir retkarčiais pateikiami patvirtinimai nuramina vartotoją. Viso proceso tyla kelia įtarimą, o staigus automatizavimas be paaiškinimo sukelia panašų nepasitikėjimą. Pradedantieji pageidauja žingsnis po žingsnio paaiškinimų ir minkštų patikros taškų, kai veiksmai turi apčiuopiamų pasekmių — pirkimai, sąskaitų pakeitimai ar bet kas, ko negalima lengvai atšaukti. Ekspertai, priešingai, nori, kad agentas elgtųsi labiau kaip patikimas kolega, o ne kaip atsargus asistentas.

Pasitikėjimas: trapus ir greitai pažeidžiamas

Tyrimas rodo, kad pasitikėjimas elgiasi kaip stiklas: trapus ir greitai įskilęs. Paslėptos prielaidos ar smulkios klaidos mažina pasitikėjimą daug greičiau nei sklandi veikla jį kuria. Kai agentas nukrypsta nuo scenarijaus arba susiduria su dviprasmiškumu, dalyviai pageidavo, kad jis sustotų ir užduotų klausimą, o ne spėliotų ir veiksmuotų. Net jei papildomas patvirtinimas kartais atrodė šiek tiek erzinantis, vartotojai dažniau rinkosi saugumą — geriau paklausti negu veikti neteisingai.

Dizaino rekomendacijos

Sukurkite AI agentus, kurie pritaiko skaidrumo ir kontrolės lygį pagal užduotį ir vartotojo patirtį.

Praktinės pasekmės dizaineriams ir programų kūrėjams yra konkrečios. Sukurkite sąsajas, kurios rodo ketinimą ir pažangą; leiskite vartotojams lengvai stabdyti ar taisyti veiksmus; ir reguliuokite pateikiamų paaiškinimų kiekį pagal užduoties svarbą bei vartotojo įgūdžių lygį. Tyrimas pateikia naudojamą rėmą — ne teorinį dekorą — formuoti šiuos sprendimus: keturios kategorijos ir dešimtys savybių, kurias galite išbandyti, iteruoti ir matuoti pagal tikrą vartotojų elgseną.

Pagrindinės UX gairės

- Rodykite ketinimus: aiškiai nurodykite, ką agentas ketina daryti prieš pradėdamas atlikti reikšmingą veiksmą.

- Vizualizuokite pažangą: naudokite žingsnių indikatorių arba progresą, kad vartotojas suprastų, kurioje proceso stadijoje yra užduotis.

- Įtraukite lengvą kontrolę: mygtukai stabdyti, anuliuoti ir koreguoti turėtų būti aiškūs ir prieinami.

- Naudokite progresinį atskleidimą: pateikite daugiau informacijos tik tada, kai to reikia arba kai vartotojas to prašo.

- Pritaikykite patvirtinimus pagal riziką: aukštos rizikos veiksmai (mokėjimai, paskyros pakeitimai) reikalauja daugiau patvirtinimų ir paaiškinimų.

Techninės priemonės ir aiškinamumas

Techniniu požiūriu, verta integruoti pasitikėjimo ir aiškumo mechanizmus: modelio pasitikėjimo įverčius, alternatyvius sprendimus su jų paaiškinimais, auditorijos žurnalus (audit trails) ir lengvai prieinamą veiksmų istoriją. „Human-in-the-loop“ sprendimai, kai tam tikri sprendimai reikalauja žmogaus patvirtinimo, sumažina riziką. Taip pat rekomenduojama numatyti saugiklius ir numatytąsias grįžtamojo ryšio formas, kad sistemos galėtų automatiškai pasiūlyti užduoties peržiūrą, jei numatyti rizikos indikatoriai pasiekia nustatytą ribą.

Praktinis patarimų kontrolinis sąrašas

Žemiau pateiktas kontrolinis sąrašas padeda komandai greitai įvertinti, ar AI agento sąsaja atitinka vartotojų lūkesčius ir UX gerąją praktiką:

- Ar agentas aiškiai komunikuoja ketinimą prieš veiksmą?

- Ar yra greitas ir intuityvus būdas sustabdyti agentą?

- Ar rizikingiems veiksmams įdiegti papildomi patvirtinimai?

- Ar pateikiama veiksmų istorija ir galimybė lengvai atšaukti paskutinius veiksmus?

- Ar sistema prisitaiko prie vartotojo patirties lygio (pradedantysis vs ekspertas)?

- Ar klaidos valdomos aiškiai ir vartotojui suprantamu būdu?

Techniniai ir organizaciniai aspektai

Be dizaino sprendimų, organizacijos turi įvertinti techninius aspektus: modelio interpretabilumą, atsarginės elgsenos mechanizmus, žurnalo ir audito reikalavimus, taip pat duomenų privatumo ir saugumo politiką. Integruojant paaiškinamumą (explainability) reikėtų atsižvelgti į tai, kad ne visi paaiškinimai yra vertingi vartotojui; kai kurie gali būti techniniai ir klaidinantys. Geriausia praktika — pateikti artimą vartotojo situacijai paaiškinimą: trumpą priežastį, alternatyvas ir parinktį paklausti daugiau.

Sklandus integravimas į produkto kūrimą

Produktų komandoms rekomenduojama įtraukti realius vartotojus į iteratyvų dizaino ciklą: greiti prototipai, A/B testavimas, telemetrijos analizė ir naudotojų testavimai su „Wizard of Oz“ metodika leidžia pastebėti jautrias vietas, kur pasitikėjimo praradimas yra tikėtinas. Be to, verta sukurti aiškius KPI, susijusius su pasitikėjimu ir klaidų tvarkymu, pvz., abortų dažnumas, patvirtinimų skaičius prieš reikšmingą veiksmą, ir vidutinis laikas, per kurį vartotojas atšaukia agento atliktą veiksmą.

Įtakos verslui ir konkurencinė perspektyva

Nesvarbu, kaip pažangios yra modelio architektūros ar kaip galingi yra LLM ir specializuoti varikliai, realią vertę suteikia santykiai tarp vartotojo ir agento. Maži dizaino sprendimai — patvirtinimas čia, matomas žingsnis ten, tinkamas sustabdymas — lemia, ar žmonės pasitikės automatizacija ar ją išjungs. Įmonės, kurios sugebės sukurti patikimą ir adaptuojamą sąsają, turės konkurencinį pranašumą rinkoje, kur vartotojo pasitikėjimas yra pagrindinis produktų sėkmės rodiklis.

Išvados

Tyrimas pateikia vertingą gairių rinkinį dizaineriams ir inžinieriams: svarbu ne tik kurti išmanesnius modelius, bet ir protingesnius sąveikos modelius. Trumpuoju laikotarpiu mažos sprendimų detalės — tinkamas patvirtinimo langelis, matomas tarpžingsnis, laiku sustabdytas veiksmas — formuos, ar vartotojai priims automatizaciją kaip patikimą pagalbininką. Investicijos į skaidrumą, adaptuojamą kontrolę ir aiškų klaidų valdymą atsipirks per didesnį vartotojų pasitenkinimą, mažesnį klaidų skaičių ir didesnį produkto naudojimo palaikymą.

Galutinė žinia aiški: AI agentai turi būti sukurti taip, kad prisitaikytų prie užduoties sudėtingumo ir vartotojo patirties. Tik taip galime sukurti sprendimus, kurie yra ne tik techniškai pažangūs, bet ir žmogui suprantami bei patikimi.

Šaltinis: smarti

Komentarai

Marius

Na skamba logiškai bet vis tiek nervina tas tylos momentas. Jei AI ką nors pakeis be aiškaus patvirtinimo aš stabdysiu, net jei erzins. Reikėtų daugiau progresinių paaiškinimų.

Palikite komentarą