9 Minutės

Įvadas: kas nutiko OpenAI viduje

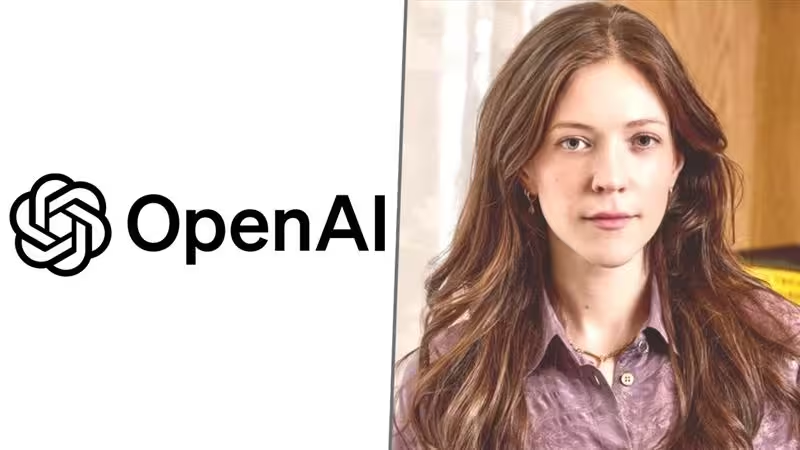

Kas nutraukia projektą ar idėją, kai vidinė politikos nuostata susiduria su produktų ambicijomis? Šis klausimas tapo antrašte šią žiemą po staigaus Ryan Beiermeister, OpenAI produktų politikos viceprezidento, pasitraukimo.

Pagal Wall Street Journal ataskaitą, jis buvo atleistas sausį po to, kai jį apkaltino lyties diskriminacija vienas vyras, dirbęs toje pačioje įmonėje. Beiermeister neigia šį kaltinimą. „Tvirtinimas, kad aš diskriminavau bet ką, yra paprasčiausiai neteisingas“, – trumpai sakė jis žurnalui.

Šis atleidimas sulaukė papildomo dėmesio, nes įvyko besitreniruojant diskusijai dėl planuojamos „ChatGPT“ funkcijos, vadinamos „suaugusiųjų režimu“ (angl. "adult mode"). Fidji Simo, OpenAI vartotojų programų vadovė, jau buvo pranešusi žurnalistams, kad ši funkcija turėtų būti paleista pirmąjį ketvirtį. Toks laiko planas sukėlė nuostabą tiek įmonės viduje, tiek už jos ribų.

Kontekstas: „suaugusiųjų režimo“ ginčas

Pasak kelių šaltinių, Beiermeister ir kiti darbuotojai išsakė prieštaravimus. Jų pagrindinė baimė buvo, kaip atviras ar leidžiantis režimas galėtų paveikti pažeidžiamus vartotojus bei kompanijos saugumo apsaugos mechanizmus. Čia egzistuoja kompromisas: viena vertus, vartotojų poreikis mažiau ribojimų ir didesnė kontrolė, kita vertus – rizika, kad valdymo atlaisvinimas gali atverti vartotojus žalai.

Tai klasikinė produktų prieš politiką dilema, tačiau ji įgauna ypatingą reikšmę kompanijoje, kurios įrankiai formuoja tai, ką milijonai žmonių mato ir girdi internete. Sprendimai čia turi didesnį socialinį svorį nei daugelyje kitų sektorių.

Bylos eiga ir viešoji reakcija

OpenAI pateikė versiją, kad Beiermeister išėjimas nėra susijęs su jo keltais politikos klausimais. Įmonė teigė, jog jis buvo atostogose, o per savo kadenciją prisidėjo prie vertingos darbo. Visgi laikas, kada įvyko pasikeitimas, skatino spekuliacijas. Kai vidiniai nesutarimai dėl aukšto profilio produkto pakeitimų sutampa su staigiais personalo judesiais, stebėtojai natūraliai svarsto — kas buvo priežastis ir kas pasekmė.

Tokiomis akimirkomis viešas pasitikėjimas ir reputacija ypač pažeidžiami: pranešimai apie atleidimus tampa naujienų antraštėmis, o kiekvienas pareiškimas yra skenuojamas ieškant užuominų apie platesnį organizacinį konfliktą.

Beiermeister patirtis ir kodėl jo nuomonė svarbi

Beiermeister gyvenimo aprašymas paaiškina, kodėl jo balsas turėjo svorio įmonės viduje. Jo LinkedIn profilis rodo maždaug ketverių metų darbo Meta produktų komandoje ir daugiau nei septynerių metų darbo Palantir — patirtis, kuri susieja produktų dizainą su operacine ir etine kompleksija. Tokia biografija dažnai reiškia, kad asmuo supranta ne tik techninius bei vartotojų poreikius, bet ir platesnes saugumo, privatumo bei reguliavimo pasekmes.

Todėl jo skepticizmas dėl plačios, nefiltruotos pokalbių funkcijos galėjo būti pagrįstas tiek praktiniais, tiek etiniais argumentais: kaip užtikrinti, kad algoritmai nepropaguotų žalingos informacijos, kaip apsaugoti pažeidžiamas grupes, kaip išlaikyti atitiktį teisės aktams. Tokie aspektai yra ypač svarbūs diegiant funkcijas, kurios gali platinti suaugusiems skirtą arba netinkamą turinį.

Techniniai ir etiniai aspektai: saugumo užtvaros ir rizikos valdymas

Debatai apie „suaugusiųjų režimą“ atveria techninių ir etinių klausimų rinkinį. Techniniu požiūriu, leidžianti arba mažiau griežta filtravimo nuostata reikalauja sudėtingesnės vartotojo autentifikacijos, amžiaus patvirtinimo mechanizmų, bei pažangių modelių, gebančių skirtis tarp teisėto suaugusiųjų turinio ir žalingo ar neteisėto turinio. Be to, reikalingas nuolatinis stebėjimas ir duomenų analizė, siekiant aptikti piktnaudžiavimą ar nepageidaujamus pokyčius sistemos veikime.

Etiškai tai reiškia diskusiją apie atsakomybę: kiek laisvės suteikti vartotojams, kai laisvė gali sukelti žalą kitiems? Kur yra riba tarp kūrybinės laisvės ir saugumo? Kas atsako už technologijos pateiktas rekomendacijas ar generuotą turinį? Šie klausimai yra kertiniai dirbtinio intelekto etikos diskusijose ir tampa dar aktualesni, kai funkcija gali paveikti plačias auditorijas.

Reguliavimo ir rinkos spaudimas

OpenAI šiuo metu balansuoja tarp kelių spaudimų: reguliuotojų reikalavimų užtikrinti saugesnę dirbtinio intelekto plėtrą, vartotojų pageidavimų dėl didesnės kontrolės ir vadovų ambicijų greičiau išleisti konkurencingas funkcijas. Europos Sąjungoje ir keliuose kituose regionuose reguliavimo kalba apie AI saugą, skaidrumą ir rizikos mažinimą sustiprėjo — tai turi tiesioginį poveikį produktų dizainui ir paleidimo strategijoms.

Be to, rinka verčia kompanijas greitai inovuoti. Konkurencinė aplinka, kurioje produktai nuolat atnaujinami ir vartotojų lūkesčiai auga, gali stumti lyderius rizikuoti ar priimti kompromisus, kurie priešingu atveju būtų atidžiau apsvarstyti. Būtent tokiame spaudime kyla vidiniai konfliktai tarp politikos specialistų, saugumo komandų ir produktų vadovų.

Vidinė dinamika ir pasitikėjimo išbandymas

Kai vadinamoji „produktų-versus-politikos“ dilema tampa realybe, organizacijos susiduria su sudėtinga vidine dinamika. Keletas aspektų, kuriuos verta paminėti:

- Sprendimų priėmimo struktūra: ar saugumo ir politikos komandos turi realią galią blokuoti produkto paleidimą, ar tokius sprendimus priima aukštesnio lygio vadovai? Organizuota hierarchija ir aiškios atsakomybės padeda išvengti chaoso, bet gali ir sulėtinti sprendimų priėmimą.

- Skaidrumas ir komunikacija: kaip aiškiai argumentai ir rizikos vertinimai yra komunikuojami tarp komandų? Atviri forumai ir aiškios dokumentacijos gali sumažinti nesusipratimus.

- Reputacijos valdymas: viešieji atleidimai ir vidiniai konfliktai gali pakenkti vartotojų ir reguliatorių pasitikėjimui. Tai reikalauja atsargaus PR ir konsoliduotos žinutės, kuri būtų suderinta su faktinėmis verslo ir saugumo vertybėmis.

Konkrečių kaltinimų ir privatumo ribos

Kol kas lyties diskriminacijos kaltinimo detalės lieka privatumui neprieinamos už pradinio pranešimo ribų. Tai reiškia, kad išorės stebėtojai, žiniasklaida ir reguliatoriai turi ribotą informacijos kiekį vertinimams. Tačiau pačios diskusijos apie „suaugusiųjų režimą“ yra aiškios: kompanija kovoja dėl to, kur nubrėžti ribą tarp laisvės ir atsakomybės, plečiant pokalbinio AI pasiekiamumą.

Tuo pačiu metu tokios bylos parodo, kiek jautri yra reputacija ir teisinis rizikos valdymas technologijų sektoriuje. Net nepilnai atskleisti incidentai gali turėti ilgalaikių pasekmių, ypač kai jie susiję su diskriminacijos ar piktnaudžiavimo įtarimais.

Pasekmės pramonei ir standartų formavimui

Kaip OpenAI atsakys į šią dilema, formuos ne tik konkretų produktą, bet ir platesnius pramonės standartus. Didžiausi AI tiekėjai dažnai tampa nukreipimo taškais — jų sprendimai dėl saugumo, skaidrumo ir vartotojų apsaugos gali tapti precedentu kitiems. Tai reiškia, kad atskiros kompanijos vidiniai sprendimai gali turėti įtakos teisėkūrai, pramonės gairėms ir vartotojų pasitikėjimui visoje ekosistemoje.

Be to, viešieji ginčai ir personalo pokyčiai dažnai paskatina reguliatorius ir pramonės asociacijas skubiau formuoti gairias bei standartus, kad būtų mažiau neaiškumų ateityje. Tokiu būdu situacijos, kurios iš pradžių atrodo kaip vienos įmonės problemos, gali paskatinti platesnius organizuotus veiksmus siekiant didesnio skaidrumo ir saugumo dirbtinio intelekto naudojime.

Praktiniai sprendimai ir rekomendacijos

Remiantis šio konflikto analize, kelios rekomendacijos organizacijoms, kurios kuria pokalbinį AI arba planuoja leidimus, gali padėti sumažinti riziką:

- Aiškios politikos ir sprendimų naštos nustatymas: apibrėžti, kurie sprendimai reikalauja politikos komandos pritarimo, o kurie tenka produktų vadovams.

- Sklandus konfliktų sprendimo mechanizmas: įdiegti neutralius peržiūros komitetus ar trečiųjų šalių ekspertų tarybas, kurios gali vertinti etines ir saugumo pasekmes.

- Vartotojo apsaugos priemonės: amžiaus patikra, patobulinti filtravimo įrankiai ir aiškūs vartotojų sutikimai su saugumo instrukcijomis.

- Skaidrumas ir komunikacija: viešinti saugumo testavimo metodikas, pateikti aiškią informaciją apie rizikas ir priemones, kurios yra diegiamos siekiant apsaugoti vartotojus.

- Reguliacinio atitikties integracija: planuoti produktų paleidimus atsižvelgiant į esamus ir numatomus teisės aktus, įtraukti teisės komandą nuo ankstyvų stadijų.

Išvados: platesnė reikšmė ir ateities perspektyvos

OpenAI atvejis – tai pavyzdys, kaip technologijų įmonė susiduria su pasirinkimu tarp produktų konkurencingumo ir vidinės politikos bei etikos principų. Beiermeister bylos aplinkybės, nesvarbu, kaip jos galiausiai bus paaiškintos, parodo, kad sprendimai technologijų produktų srityje nebėra vien tik inžineriniai: juos lemia etika, teisė ir viešoji atsakomybė.

Taip pat aišku, kad tokie ginčai yra neišvengiami sparčiai vystantis AI technologijoms. Organizacijos, kurios sugebės sutvirtinti vidaus sprendimų priėmimo procesus, išlaikyti skaidrumą ir integruoti saugumo bei atitikties praktikas į produktų kūrimo ciklą, turės didesnę tikimybę išlaikyti pasitikėjimą tiek vartotojų, tiek reguliatorių akyse.

Galiausiai, atsakymas į klausimą, kur nubraukti ribą tarp laisvės ir atsakomybės — ne tik techninis, bet ir politinis bei socialinis. OpenAI sprendimas šioje situacijoje formuos ne tik vieną funkciją, bet ir platesnę pramonės praktiką bei lūkesčius dėl to, kaip turėtų būti valdoma pokalbinio dirbtinio intelekto plėtra.

Santrauka: pagrindiniai pastebėjimai

- Ryan Beiermeister atleidimas atkreipė dėmesį į vidinius OpenAI nesutarimus dėl „suaugusiųjų režimo“.

- Debatai parodo įtemptą balansą tarp produktų inovacijų, vartotojų laisvės ir saugumo bei etikos reikalavimų.

- Reguliacinis spaudimas, rinkos konkurencija ir vidinė organizacinė dinamika daro sprendimus dar sudėtingesnius.

- Rezultatai gali formuoti platesnius pramonės standartus dėl AI saugumo, skaidrumo ir atsakomybės.

Ką stebėti toliau

Stebėkite OpenAI viešus pranešimus, reguliatorių veiksmus ir pramonės reakcijas. Šios istorijos eiga leis geriau suprasti, kaip technologijų lyderiai derins greitą inovacijų diegimą su visuomenine atsakomybe ir saugumo reikalavimais.

Šaltinis: smarti

Palikite komentarą